¿Alguna vez has sentido que tus datos son como cajas desperdigadas por toda la casa? Facturas en un cajón, correos en el móvil, fotos en la nube… y cuando más los necesitas, desaparecen. Un data lake —o lago de datos— es esa habitación amplia y ordenada donde puedes guardar todo sin perderlo, para después convertirlo en decisiones inteligentes. Hoy te cuento, sin tecnicismos innecesarios, qué es un data lake, cómo se diferencia de un almacén, qué piezas lo componen y cómo arrancarlo sin acabar en un “pantano de datos”. ¿Listo para poner orden?

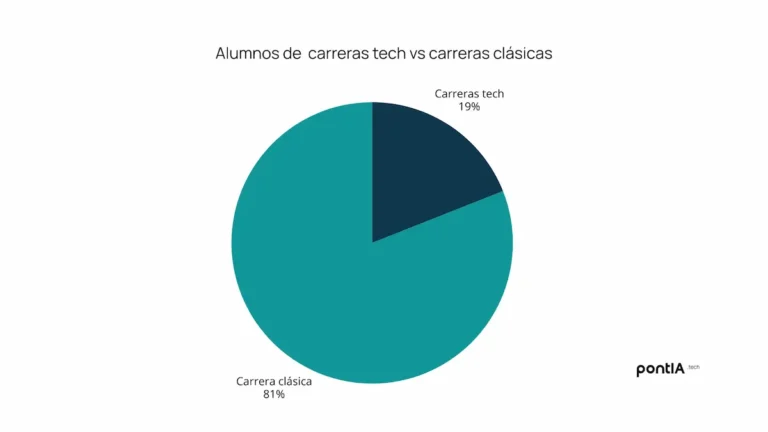

¿Te estás planteando saber mas sobre Inteligencia Artificial y Big Data?

En Pontia Tech te ofrecemos másteres diseñados específicamente para profesionales como tú: con experiencia técnica, ganas de crecer y visión de futuro.

Imagina lo que podrías lograr al combinar tu base en programación con habilidades punteras en IA generativa, Data Science o Analytics.

🎓 Máster en Data Analytics online

🎓 Máster en Data Science online

🎓 Máster en Inteligencia Artificial, Cloud Computing y DevOps

🎓 Máster en Data Analytics & Science

¿Qué es un data lake?

Un data lake es un repositorio central en la nube donde puedes almacenar todos tus datos tal cual llegan, sin obligarte a definir un esquema rígido por adelantado. Si te estás preguntando qué es un data lake, piensa en un lago de datos real: ríos que traen información de muchas fuentes. Aquí esos “ríos” son logs, hojas de cálculo, datos de sensores IoT, imágenes, audio, vídeos o tablas de negocio. Todo entra a bajo coste y queda listo para usarse después.

La magia de un data lake está en que no discrimina formatos: datos estructurados (tablas), semiestructurados (JSON, CSV) y no estructurados (PDF, imágenes). ¿La ventaja? Escalabilidad casi ilimitada, costes ajustados por almacenamiento de objetos y libertad para analizarlos cuando te haga falta. Si alguien te pregunta qué es un data lake, esta es la idea clave: guarda primero, decide después.

Schema on read: por qué importa

En un data lake impera el enfoque schema on read: primero guardo, luego decido cómo leer. En vez de diseñar toda la estructura antes (como en un almacén), aquí los analistas definen el esquema en el momento del análisis. ¿Qué consigues? Velocidad para ingestar datos hoy y flexibilidad para hacer nuevas preguntas mañana. Por eso, cuando te pregunten qué es un data lake moderno, la respuesta incluye schema on read, ELT y libertad para iterar.

Data lake vs data warehouse

Diferencias clave y cuándo usar cada uno

Piensa en el data warehouse como una biblioteca: libros ordenados, estanterías etiquetadas, todo impecable, perfecto para reporting de negocio (BI). El data lake es la bodega amplia donde guardas todo sin decidir todavía la estantería; ideal para ciencia de datos, inteligencia artificial (IA) y machine learning (ML). Esta tabla te ayudará a comprender las diferencias:

|

Criterio |

Data lake |

Data warehouse |

|

Tipo de datos |

Cualquiera (estruct., semi, no estruct.) |

Principalmente estructurados |

|

Esquema |

Schema on read (flexible) |

Schema on write (definido antes) |

|

Coste almacenamiento |

Bajo (objetos en la nube) |

Medio/alto |

|

Casos típicos |

Descubrimiento, IA/ML, IoT, exploración |

KPIs estables, BI, informes |

|

Latencia |

Variable (batch + streaming) |

Baja para consultas repetitivas |

|

Gobierno |

Flexible, requiere catálogo y normas |

Rígido, más curado de origen |

¿Y cuál te conviene? Si tu prioridad es explorar, prototipar modelos y romper silos, el data lake gana. Si necesitas informes fiables cada lunes a las 9:00, el almacén brilla. En muchos casos, necesitas ambos.

Arquitectura lakehouse: el punto intermedio

¿Qué pasa si quieres lo mejor de los dos mundos? Entra la arquitectura lakehouse: mantiene el almacenamiento barato y elástico del data lake, pero añade gestión de tablas, transacciones, gobierno de datos y rendimiento SQL más cercano al almacén. Para equipos que preguntan qué es un data lake moderno que sirva para BI e IA a la vez, la respuesta apunta a lakehouse.

¿Quieres sacar aún más partido a la inteligencia artificial?

Hemos preparado una guía práctica y totalmente gratuita de ChatGPT con ejemplos, trucos y prompts listos.

👉 Descárgala ahora gratis y descubre cómo la IA puede convertirse en tu mejor aliada.

Componentes esenciales de un data lake

Ingesta de datos y canalizaciones (ETL vs ELT)

Para que el lago de datos tenga agua, hay que alimentarlo. Dos enfoques:

- ETL (Extracción, Transformación y Carga): transformas antes de cargar. Útil cuando ya has definido métricas y campos.

- ELT (Extracción, Carga y Transformación): cargas primero tal cual al data lake y transformas luego. Ideal para agilidad y descubrimiento.

Buenas prácticas: automatiza la ingesta, añade validaciones de calidad de los datos (conteos, formatos, duplicados) y registra metadatos desde el minuto uno. Así tu lago de datos no deriva en data swamp.

Almacenamiento de objetos en la nube

El corazón físico del data lake es el almacenamiento de objetos en la nube. Es barato, elástico y duradero. Aquí viven tus ficheros, listos para procesarse cuando quieras.

Amazon S3

Amazon S3 es uno de los destinos más comunes para un data lake. Ofrece alta durabilidad, clases de almacenamiento para optimizar costes, versionado y políticas de ciclo de vida. ¿Te imaginas cuánto podrías ahorrar ajustando los históricos a clases “cool” o “archive” en tu lago de datos?

Azure Blob Storage

Azure Blob Storage destaca por su integración con el ecosistema de Azure y sus capas de acceso. Permite cifrado por defecto y control granular con gestión de identidades y accesos (IAM).

Google Cloud Storage

Google Cloud Storage es simple y potente, con multi-región, clases flexibles y buen rendimiento. Brilla en ingesta masiva y acceso global de baja latencia para lago de datos con múltiples equipos.

IBM Cloud Object Storage

IBM Cloud Object Storage aporta resiliencia y distribución geográfica. Es una alternativa sólida cuando tu organización ya trabaja con el ecosistema IBM o busca diversidad de proveedores para su data lake.

Catálogo de datos y metadatos

Sin metadatos no hay descubrimiento. El catálogo de datos describe qué hay, de dónde viene y quién puede usarlo. Incluye descripciones, linaje, propietarios, sensibilidad y clasificación. Si alguien te pide que le expliques otra vez qué es un data lake bien gestionado, la respuesta siempre incluye catálogo y metadatos.

Gobierno de datos y calidad

El gobierno de datos marca las reglas del juego: propiedad, accesos, políticas, retención y calidad. Define roles claros (data owners, stewards), estándares de nomenclatura, formatos (Parquet, ORC) y controles (completitud, unicidad, validez). Un data lake sin gobierno acaba siendo un data swamp. Evítalo.

Seguridad: IAM, cifrado y accesos

La seguridad de datos no es negociable. Implementa IAM de mínimo privilegio, cifrado en reposo y tránsito, tokenización para datos sensibles, auditorías y segregación por zonas (crudo, preparado, curado). Los data lakes seguros protegen tu reputación y cumplen normativas.

Tecnologías habituales para análisis

Apache Hadoop y ecosistema

Apache Hadoop popularizó el procesamiento distribuido. Aunque hoy domina el almacenamiento de objetos en data lakes, muchas ideas de su ecosistema sobreviven en herramientas modernas y siguen siendo útiles para cargas batch.

Apache Spark para procesamiento

Apache Spark es el motor estrella de procesamiento distribuido para ETL/ELT, ML y SQL a gran escala. Permite transformar datos del data lake a alta velocidad y ejecutar algoritmos de machine learning en pipelines productivos. Si te piden qué es un data lake listo para analítica, Spark suele estar en la foto.

Motores SQL: Presto/Trino

Si tu equipo ama SQL, motores como Presto/Trino permiten consultar datos directamente en el data lake, uniendo diferentes fuentes sin moverlos. Perfecto para analistas que quieren responder preguntas en minutos.

Integración con BI y visualización

El data lake no vive aislado. Conecta con herramientas de inteligencia empresarial (BI) y visualización de datos para cuadros de mando. Crea vistas curadas (zonas “gold”) para negocio y deja la zona cruda a data scientists.

Casos de uso de data lakes

IoT y análisis en tiempo real

Sensores, dispositivos, máquinas… El Internet de las Cosas (IoT) genera torrentes de información. Un data lake recibe esos eventos, los almacena y permite análisis en tiempo real: detección de anomalías, mantenimiento predictivo, optimización de rutas. ¿Te imaginas parar una avería antes de que ocurra gracias a tu data lake?

Ciencia de datos, IA y Machine Learning

Los científicos de datos necesitan variedad y volumen para entrenar modelos de IA y ML. El data lake es su “patio de pruebas”: etiquetado, feature stores, entrenamiento y validación. Con pipelines bien armados, pasas de notebooks a modelos en producción. Esta es otra forma de explicar qué es un data lake: el habilitador natural de IA en la empresa.

Eliminación de silos de datos en la empresa

¿Te duele ver silos de datos en cada departamento? Los data lakes centralizan y democratizan el acceso con gobierno y permisos adecuados. Finanzas y marketing comparten definiciones y aceleran decisiones. Dejas de discutir por el número y te centras en el porqué. Data lake = personas alineadas.

Buenas prácticas para evitar el “data swamp”

Modelado ligero y organización por zonas

Organiza el data lake en zonas:

- Raw/Cruda: datos tal cual llegan al lago de datos.

- Silver/Preparada: datos limpios y conformados.

- Gold/Curada: datos listos para negocio y BI.

Usa nombres coherentes, particiona por fecha o entidad y aplica formatos columnares. Este modelado ligero (medallion) mantiene orden sin perder la flexibilidad que define qué es un data lake.

Trazabilidad, linaje y control de versiones

Define linaje de datos: de dónde vienen, cómo se transforman, adónde van. Activa versionado en el almacenamiento de objetos (Amazon S3, Azure Blob, Google Cloud Storage o IBM Cloud Object Storage) y registra cambios en pipelines. ¿Has roto un informe? Con versionado y linaje en tu lago de datos, puedes volver atrás y entender qué pasó.

Monitorización de calidad y costes

Establece SLOs de calidad (completitud, consistencia) y alertas proactivas. Además, vigila costes: clases de almacenamiento adecuadas, compresión, particionado y cachés. La escalabilidad de un data lake es un superpoder, pero también puede disparar facturas si no la controlas.

Pasos para empezar con tu data lake

Elegir la nube y el almacenamiento

Selecciona la nube que mejor encaje con tu realidad (equipo, acuerdos, herramientas): Amazon S3, Azure Blob Storage, Google Cloud Storage o IBM Cloud Object Storage. Prioriza seguridad, coste, regiones y ecosistema analítico disponible. Si te vuelven a preguntar qué es un data lake aplicado, es esta combinación de decisiones técnicas y de negocio.

Diseñar la ingesta y el catálogo

Empieza con dos o tres fuentes clave (por ejemplo CRM, web y operaciones) y automatiza ingesta incremental. Levanta desde el inicio un catálogo de datos con metadatos útiles: descripción, propietario, sensibilidad, frecuencia de actualización y linaje.

Definir gobierno y seguridad desde el día uno

No lo dejes para después. Establece políticas de acceso con IAM, cifrado, enmascaramiento para datos personales, roles y responsabilidades claras y revisiones periódicas. Un data lake que respeta el gobierno de datos genera confianza y acelera adopción.

Primeros casos de uso y escalabilidad

Elige un caso de negocio pequeño pero visible: un panel de BI con ventas diarias, un modelo de propensión en marketing o un piloto de anomalías IoT. Mide impacto, recoge feedback y escala.

Errores comunes y cómo solucionarlos

Falta de metadatos y descubrimiento

Error: guardar ficheros sin metadatos ni catálogo.

Solución: exige descripciones, esquemas, clasificaciones y linaje para cada dataset. Haz que catalogar sea parte del pipeline, no un favor de última hora en tu data lake.

Costes descontrolados

Error: dejar todo caliente y sin ciclo de vida.

Solución: políticas de lifecycle, clases de almacenamiento adecuadas, compresión, particionado y revisión mensual de consumo.

Accesos y permisos mal definidos

Error: roles genéricos y “acceso para todos”.

Solución: principio de mínimo privilegio, IAM granular, auditoría continua y separación por zonas (raw, silver, gold).

Recomendación final

Un data lake no es solo tecnología: es una forma de trabajar con datos que prioriza flexibilidad, escalabilidad y aprendizaje continuo. Te permite romper silos, centralizar la información y habilitar BI, IA y machine learning con una base sólida. Si alguien te vuelve a preguntar qué es un data lake, recuerda estas tres ideas: guardar todo, descubrir valor y gobernar con cabeza.

Si hoy tus datos están dispersos y cada informe tarda semanas, un lago de datos puede ser el cambio que necesitas. Empieza pequeño: elige tu nube, automatiza la ingesta (ELT/ETL), levanta un catálogo y habilita consultas SQL con motores tipo Presto/Trino o procesamiento con Apache Spark. Con cada paso, verás cómo tus decisiones se vuelven más rápidas, claras y confiables.

Preguntas frecuentes (FAQs)

¿Qué es exactamente un data lake y en qué se diferencia de un data warehouse?

Un data lake (lago de datos) guarda todo tipo de datos (estructurados, semiestructurados y no estructurados) de forma económica en almacenamiento de objetos y aplica schema on read: decides el esquema al analizar. Un data warehouse almacena datos ya transformados y estructurados (schema on write) para BI y reporting estable. El data lake es flexible y exploratorio; el warehouse es curado y orientado a KPIs repetibles. Muchas empresas usan ambos o evolucionan a lakehouse.

¿Cómo evito que mi data lake se convierta en un “data swamp”?

Implanta catálogo de datos y metadatos, define zonas (raw, silver, gold), aplica gobierno de datos (roles, políticas, linaje), controla calidad (validaciones, SLOs) y costes (clases de almacenamiento, compresión, particionado). Añade auditoría, versionado y permisos IAM de mínimo privilegio. La regla de oro: cada dataset entra con dueño, descripción y propósito.

¿Qué nube y almacenamiento son mejores para un data lake?

Depende de tu contexto. Las opciones habituales son Amazon S3, Azure Blob Storage, Google Cloud Storage e IBM Cloud Object Storage. Compara coste total, regiones, integración con tus herramientas (Spark, Presto/Trino, BI), seguridad y soporte. Prioriza lo que reduzca time-to-value y facilite el gobierno.

¿Qué casos de uso iniciales recomiendas para demostrar valor rápido?

Tres apuestas seguras: panel de BI de ventas/operaciones con datos unificados; casos de marketing (propensión, churn) con machine learning; y IoT/anomalías para mantenimiento predictivo. Son visibles, medibles y muestran el poder del data lake para romper silos de datos.

¿Es seguro un data lake?

Sí, si aplicas buenas prácticas: cifrado en tránsito y en reposo, IAM granular, tokenización/enmascaramiento para datos sensibles, segmentación por zonas y auditorías periódicas. Añade monitorización y respuesta a incidentes. La seguridad es parte del diseño, no un añadido final.

Accede a másteres profesionales en IA y Data Science

Nuestros másteres te preparan para liderar proyectos de inteligencia artificial, integrando soluciones como Amazon Bedrock, machine learning, data analytics y mucho más.

¿Te gustaría crear tu primer proyecto con IA? ¿O dominar esta tecnología para avanzar profesionalmente? Entonces no esperes más.

Descubre nuestros másteres en IA Generativa y Big Data en Pontia Tech y empieza hoy mismo a construir el futuro.

Descubre cómo nuestro máster en Big Data e IA puede transformar tu perfil profesional. ¡Solicita información hoy mismo!

🎓 Máster en Data Analytics online

🎓 Máster en Data Science online

🎓 Máster en Inteligencia Artificial, Cloud Computing y DevOps

🎓 Máster en Data Analytics & Science